AviFact

Das Projekt

Ziele des Projektes

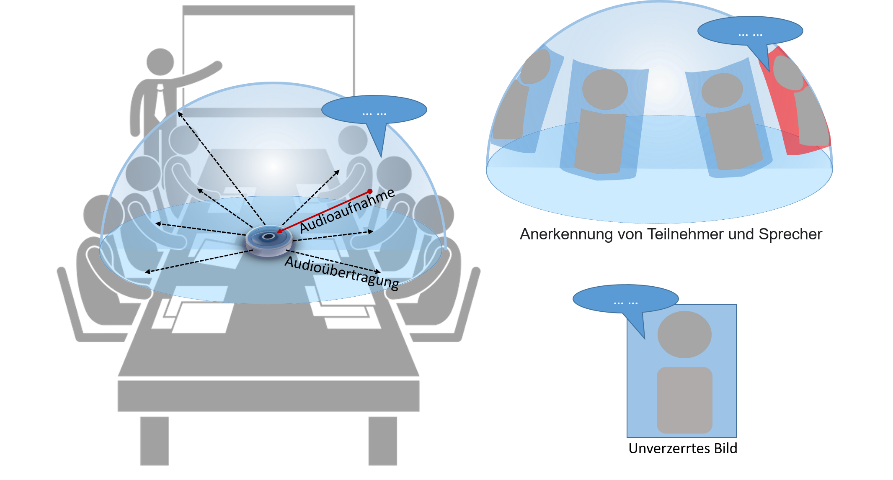

Ziel dieses Kooperationsprojektes ist die Erforschung und Weiterentwicklung von Technologien zur robusten Fernfeld-Sprachinteraktion für die Mensch-zu-Mensch-Kommunikation. Im Gegensatz zur Mensch-Maschine-Interaktion (Spracherkennung, Transkription, Sprachsteuerung) ist hier fast immer bidirektionale Kommunikation gemeint. Während die Technologien zur Spracherfassung aus größeren Entfernungen für viele Anwendungsfälle bereits fortgeschritten sind, wurde in Forschung und Entwicklung bisher wenig Fokus auf eine hochqualitative Sprachausgabe gelegt. Ein Schwerpunkt des Projekts liegt daher auf der Entwicklung innovativer Technologien zur gerichteten Schallabstrahlung. Analog zur Richtwirkung von Mikrofonen sollen dazu mehrere Lautsprecher koordiniert so angesteuert werden, dass die Sprachausgabe nur in die gewünschten Richtungen erfolgt. Daraus ergeben sich mehrere Vorteile für die Zuhörer, u.a. eine bessere Sprachverständlichkeit und damit einhergehende Verringerung von Ermüdungserscheinungen. Als Grundlage für die beiden vorgenannten Schwerpunkte, insbesondere zur korrekten Einstellung der Richtwirkung von Sprachaufnahme und -ausgabe, müssen in der Praxis Informationen über den Aufenthaltsort der Gesprächsteilnehmer vorliegen. Eine akustische Lokalisierung allein reicht in vielen Fällen nicht aus um z.B. anwesende Teilnehmer von Radiosprechern zu unterscheiden oder in längeren Gesprächspausen stets Ortungsinformationen zu generieren. Neben möglicherweise vorhandenem Anwendungswissen müssen darum zusätzliche Modalitäten wie bspw. visuelle Ortung genutzt werden. Vergangene Forschungsprojekte mit externen Partnern haben ergeben, dass die Kombination der Audioverarbeitung mit Ergebnissen aus einer Video-Objekterkennung ein sehr vielversprechendes Verfahren ist, um eine präzisere Lokalisierung menschlicher Sprecher und Zuhörer in herausfordernden akustischen Umgebungen zu ermöglichen.

Konzept zur Umsetzung

Die Professur DST ist verantwortlich für die Erforschung und Entwicklung der Video- und Fusionsalgorithmen. Zu den Aufgaben gehören die Entwicklung von KI-basierten Algorithmen zur Person- und Objekterkennung auf omnidirektionalen Bildern sowie deren Umwandlung in eine perspektivische Projektion für die Übertragung (Demonstrator). Auch ein Trackingfilter wird erforscht und entwickelt, um die Sprecherlokalisierung robuster zu gestalten. Im Fusionsbereich ist die Professur DST für die räumliche und zeitliche Korrelation der Ausgänge von Video- und Audiomodul verantwortlich. Die räumliche Fusion ermöglicht es, die Genauigkeit der Ortung von Schallquellen zu erhöhen sowie jeder Audiosequenz eine Person oder ein Objekt im Bild zuzuordnen. Diese Fusion erhöht das Verständnis der Szene und damit die Qualität der aufgezeichneten, gesendeten und übertragenen Signale. Durch die zeitliche Fusion werden beide Modalitäten synchronisiert, damit das Tonsignal zeitlich mit den Lippenbewegungen des jeweiligen Sprechers übereinstimmt. Gemeinsam mit dem Industriepartner wird eine multimodale Datenbank entwickelt, die zum Trainieren der KI-Algorithmen sowie zur Evaluierung des Technologie-Demonstrators verwendet wird. Der Forschungskern der Professur DST lässt sich zweiteilen in einerseits die Erforschung und Entwicklung von hocheffizienten Erkennungsalgorithmen, die mit geringen Hardwareressourcen genaue Ergebnisse bei mehr als 24 fps erreichen, um eine hinreichende Bewegungsauflösung zu erzielen. Dies erfordert die Untersuchung und Entwicklung leichtgewichtiger neuronaler Netzwerkarchitekturen, die robuste Ergebnisse auf Basis omnidirektionaler Bildern erzielen. Andererseits liegt, basierend auf der erfolgreichen Verarbeitung von Audio- und Videosignalen, eine der relevantesten Innovationen dieses Projekts in der Untersuchung der Fusion beider Modalitäten als Werkzeug zur Verbesserung der Tonqualität. Diese Fusion soll sowohl zur präzisen Lokalisierung der Schallquellen (beider Aufnahme) und -ziele (bei der Abstrahlung) als auch zur robusten Unterscheidung von Sprache und Störgeräusch beitragen.

Team

Kontakt

-

Telefon:+49 371 531-37378

-

E-Mail:

-

Adresse:Reichenhainer Straße 70, 09126 Chemnitz

-

Raum:C25.419 (alt: 2/W419)