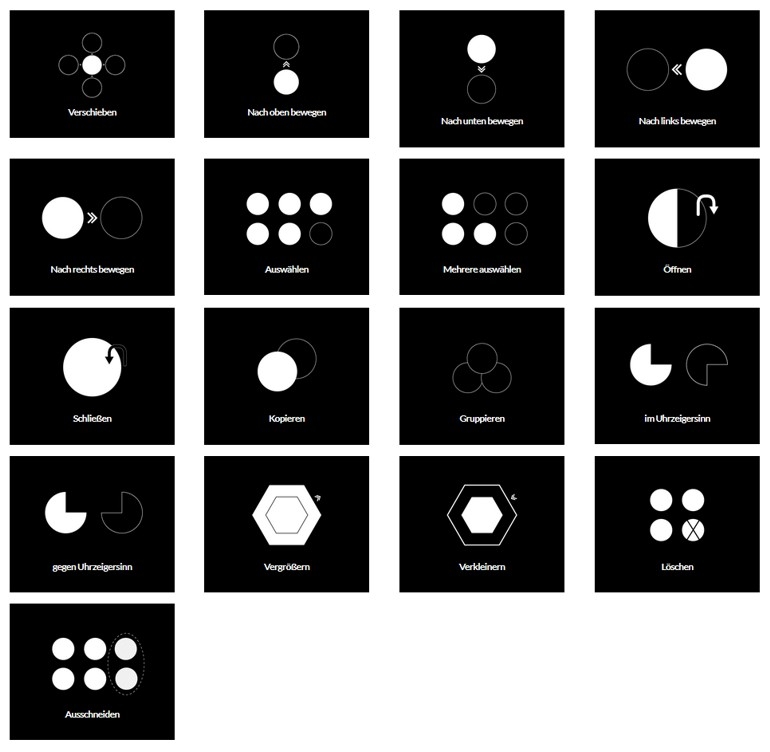

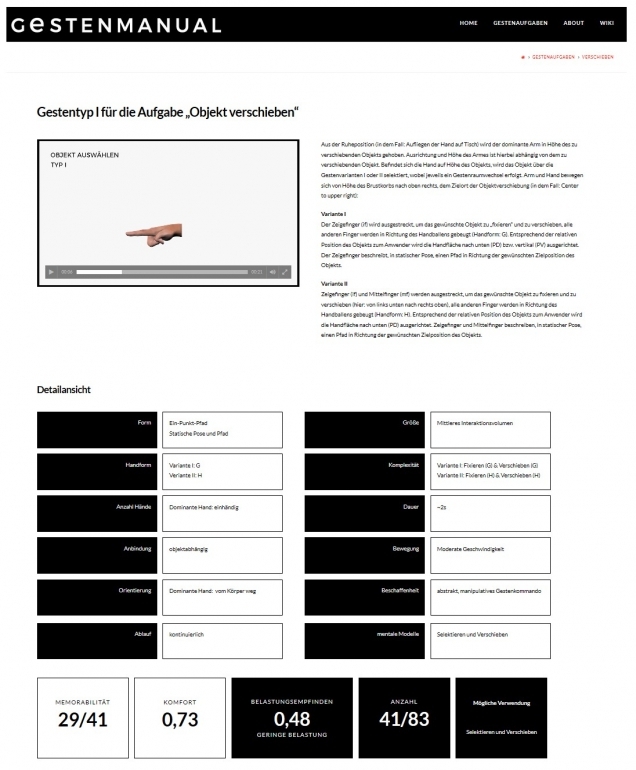

Seeling, T. , Dittrich, F., & Bullinger, A.C. (2018, February 26). Digitales Gestenmanual zur Gestaltung einer natürlichen gestenbasierten Interaktion zwischen Mensch und Maschine. [TALK]., Frankfurt/Main,

Seeling, T., & Bullinger, A. C. (2017, February 15-17). Natürliche User Interfaces mit Anwendern gestalten - Eine Handreichung für die Gestaltung intuitiver Gesten-Sets. [TALK]., Zürich,

Seeling, T.; Bullinger, A.C. (2017, September 12-15). Intuitiv bedient. Ein Gestemanual für die Gestaltung intuitiver Gesten-Sets in interaktiven Systemen [TALK]., Passau,

Fricke, E., Seeling, T., Lynn, U., Schöller, D., & Bullinger, A. (2016, July 18-22). Gesture, virtual globes and technological innovation: Metaphorical concepts as basis for gesturally steering Google Earth with Leap Motion. [TALK]., Paris,

Seeling, T., Fricke, E., Schöller, D., & Bullinger, A.C. (2016, October 06-07). Natürliche User Interfaces durch das Einbeziehen von Nutzern gestalten. Implikationen für ein Entwickler-Gestenmanual [TALK]., Dresden,

Seeling, T., Dittrich, F., Fricke, E., & Bullinger, A. C. (2016, March 02-04). Gestenbasierte Google-Earth-Bedienung. Implikationen für ein natürliches Gesten-Set am Beispiel einer 3D-Topographieanwendung [Poster presentation]., Aachen,

Fricke, E., Seeling, T., Lynn, U., Schöller, D., & Bullinger, A. (2016, June 22-24). Hände und Objekte: Perspektiven linguistischer Gestenforschung für die Gestaltung von Mensch-Maschine-Schnittstellen. [TALK]., Chemnitz,